Différence entre Hadoop et Spark

- 4721

- 880

- Elisa Petit

L'un des plus gros problèmes en ce qui concerne les mégadonnées est qu'une quantité importante de temps est consacrée à l'analyse des données qui incluent l'identification, le nettoyage et l'intégration de données. Les grands volumes de données et l'exigence d'analyse des données conduisent à la science des données. Mais souvent, les données sont dispersées sur de nombreuses applications et systèmes commerciaux qui les rendent un peu difficiles à analyser. Ainsi, les données doivent être réingérées et reformatées pour faciliter l'analyse. Cela nécessite des solutions plus sophistiquées pour rendre les informations plus accessibles aux utilisateurs. Apache Hadoop est l'une de ces solutions utilisées pour stocker et traiter les mégadonnées, ainsi qu'une multitude d'autres outils de Big Data, notamment Apache Spark. Mais lequel est le bon cadre pour le traitement et l'analyse des données - Hadoop ou Spark? Découvrons-le.

Apache Hadoop

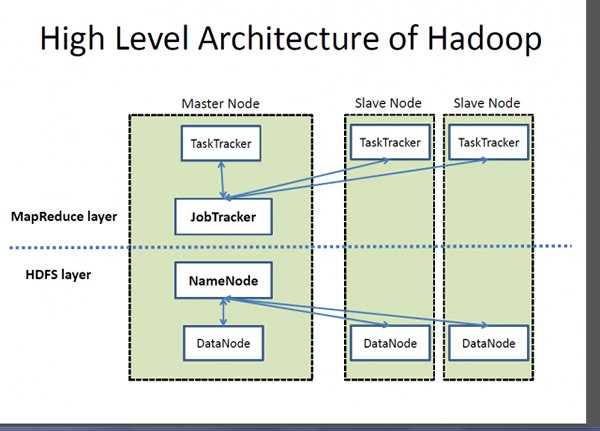

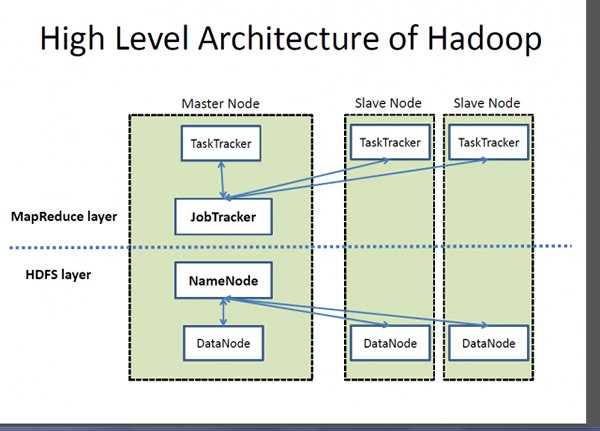

Hadoop est une marque déposée d'Apache Software Foundation et un cadre open source conçu pour stocker et traiter de très grands ensembles de données sur des grappes d'ordinateurs. Il gère des données à très grande échelle à un coût raisonnable dans un temps raisonnable. De plus, il fournit également des mécanismes pour améliorer les performances de calcul à grande échelle. Hadoop fournit un cadre de calcul pour stocker et traiter les mégadonnées en utilisant le modèle de programmation MapReduce de Google. Il peut fonctionner avec un seul serveur ou peut évoluer, y compris des milliers de machines de produits. Bien que Hadoop ait été développé dans le cadre d'un projet open source au sein de la Fondation du logiciel Apache basé sur MapReduce Paradigm, il existe aujourd'hui une variété de distributions pour Hadoop. Cependant, MapReduce est toujours une méthode importante utilisée pour l'agrégation et le comptage. L'idée de base sur laquelle MapReduce est basée est le traitement des données parallèles.

Apache Spark

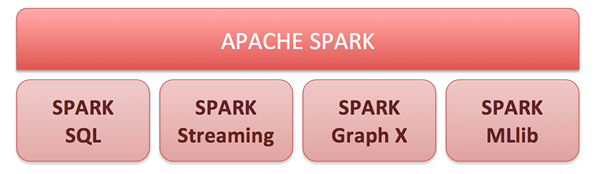

Apache Spark est un moteur de calcul de cluster open source et un ensemble de bibliothèques pour le traitement des données à grande échelle sur des clusters d'ordinateur. Construit au-dessus du modèle Hadoop Mapreduce, Spark est le moteur open-source le plus activement développé pour faire l'analyse des données plus rapidement et faire fonctionner les programmes plus rapidement. Il permet des analyses en temps réel et avancées sur la plate-forme Apache Hadoop. Le cœur de Spark est un moteur informatique composé de planification, de distribution et de surveillance des applications composées de nombreuses tâches informatiques. Son objectif de conduite clé est d'offrir une plate-forme unifiée pour rédiger des applications de mégadonnées. Spark est né à l'origine au Laboratoire APM de l'Université de Berkeley et maintenant c'est l'un des meilleurs projets open-source sous le portefeuille d'Apache Software Foundation. Ses capacités de calcul en mémoire inégalées permettent aux applications analytiques de fonctionner jusqu'à 100 fois plus rapidement sur Apache Spark que d'autres technologies similaires sur le marché aujourd'hui.

Différence entre Hadoop et Spark

Cadre

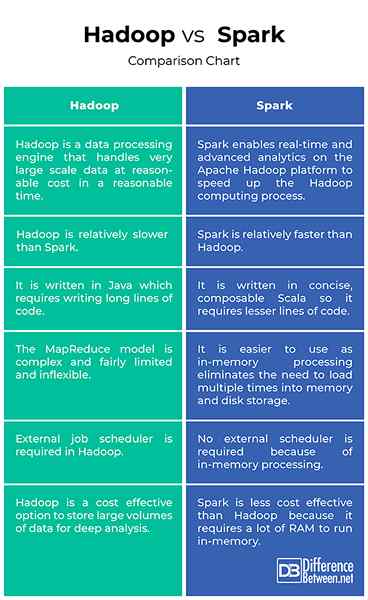

- Hadoop est une marque déposée d'Apache Software Foundation et un cadre open source conçu pour stocker et traiter de très grands ensembles de données sur des grappes d'ordinateurs. Fondamentalement, c'est un moteur de traitement des données qui gère les données à très grande échelle à un coût raisonnable dans un temps raisonnable. Apache Spark est un moteur de calcul de cluster open source construit sur le modèle MapReduce de Hadoop pour le traitement des données à grande échelle et l'analyse sur les clusters d'ordinateur. Spark permet des analyses en temps réel et avancées sur la plate-forme Apache Hadoop pour accélérer le processus informatique Hadoop.

Performance

- Hadoop est écrit en java, il faut donc écrire de longues lignes de code qui prennent plus de temps pour l'exécution du programme. La mise en œuvre à l'origine développée Hadoop MapRedEduce était innovante mais aussi assez limitée et non très flexible. Apache Spark, en revanche, est écrite dans une langue Scala concise et élégante pour faciliter la fonctionnalité et la plus rapide des programmes. En fait, il est en mesure d'exécuter des applications jusqu'à 100 fois plus rapidement que non seulement Hadoop mais aussi d'autres technologies similaires sur le marché.

Facilité d'utilisation

- Hadoop Mapreduce Paradigm est innovant mais assez limité et inflexible. Les programmes MapReduce sont exécutés par lot et ils sont utiles pour l'agrégation et le comptage à grande échelle. Spark, en revanche, fournit des API cohérentes et composables qui peuvent être utilisées pour créer une application à partir de plus petites pièces ou des bibliothèques existantes. Les API de Spark sont également conçues pour permettre des performances élevées en optimisant les différentes bibliothèques et fonctions composées ensemble dans un programme utilisateur. Et puisque Spark cache la plupart des données d'entrée en mémoire, grâce à RDD (ensemble de données distribué résilient), il élimine le besoin de charger plusieurs fois dans la mémoire et le stockage disque.

Coût

- Le système de fichiers Hadoop (HDFS) est un moyen rentable de stocker de grands volumes de données à la fois structurées et non structurées en un seul endroit pour une analyse en profondeur. Le coût par téraoctet de Hadoop est bien inférieur au coût des autres technologies de gestion des données qui sont largement utilisées pour maintenir les entrepôts de données d'entreprise. Spark, en revanche, n'est pas exactement une meilleure option en matière de rentabilité car elle nécessite beaucoup de RAM pour mettre en mémoire les données en mémoire, ce qui augmente le cluster, d'où le coût marginalement, par rapport à Hadoop.

Hadoop VS. Spark: Tableau de comparaison

Résumé de Hadoop vs. Étincelle

Hadoop n'est pas seulement une alternative idéale pour stocker de grandes quantités de données structurées et non structurées de manière rentable, elle fournit également des mécanismes pour améliorer les performances de calcul à grande échelle. Bien qu'il ait été initialement développé en tant que projet Open Source Apache Software Foundation basé sur le modèle MapReduce de Google, il existe une variété de distributions différentes disponibles pour Hadoop aujourd'hui. Apache Spark a été construite sur le modèle MapReduce pour étendre son efficacité pour utiliser plus de types de calculs, y compris le traitement des flux et les requêtes interactives. Spark permet des analyses en temps réel et avancées sur la plate-forme Apache Hadoop pour accélérer le processus informatique Hadoop.