Différence entre MapReduce et Spark

- 4534

- 1126

- Mathilde Roux

Apache Spark est l'un des projets open-source les plus actifs de l'écosystème Hadoop et l'une des technologies les plus chaudes de l'analyse des mégadonnées aujourd'hui. MapReduce et Spark sont des cadres open source pour le traitement des mégadonnées. Cependant, Spark est connu pour le traitement en mémoire et est idéal pour les cas où les données s'inscrivent dans la mémoire, en particulier sur des grappes dédiées. Nous comparons les deux principaux cadres logiciels pour vous aider à décider lequel est le bon pour vous.

Qu'est-ce que Hadoop Mapreduce?

MapReduce est un modèle de programmation dans le cadre Hadoop pour l'informatique distribuée basée sur Java. Il est utilisé pour accéder aux mégadonnées dans le système de fichiers Hadoop (HDFS). C'est une façon de structurer votre calcul qui lui permet de s'exécuter facilement sur de nombreuses machines. Il permet une évolutivité massive sur des centaines ou des milliers de serveurs dans un cluster Hadoop. Il permet d'écrire des travaux distribués et évolutifs avec peu d'effort. Il remplit deux fonctions essentielles: il filtre et distribue le travail à divers nœuds dans le cluster ou la carte. Il est utilisé pour l'analyse des données à grande échelle en utilisant plusieurs machines dans le cluster. Un framework MapReduce est généralement un processus en trois étapes: carte, mélanger et réduire.

Qu'est-ce qu'Apache Spark?

Spark est un cadre open source et super rapide Big Data largement considéré comme le successeur du framework MapReduce pour le traitement des mégadonnées. Spark est une amélioration de Hadoop à MapReduce utilisée pour les charges de travail du Big Data. Pour une organisation qui a des quantités massives de données à analyser, Spark offre un moyen rapide et facile d'analyser ces données sur un groupe entier d'ordinateurs. Il s'agit d'un moteur d'analyse unifié multicangue pour les mégadonnées et l'apprentissage automatique. Son modèle de programmation unifiée en fait le meilleur choix pour les développeurs créant des applications analytiques riches en données. Cela a commencé en 2009 en tant que projet de recherche chez UC Berkley's Amplab, un effort de collaboration impliquant des étudiants, des chercheurs et des professeurs.

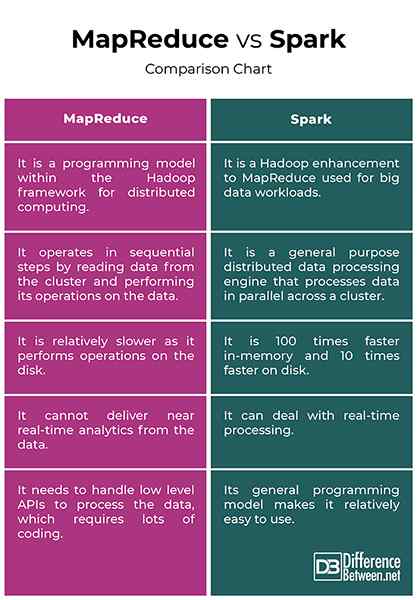

Différence entre MapReduce et Spark

Traitement de l'information

- Hadoop traite les données des lots et MapReduce fonctionne en étapes séquentielles en lisant les données du cluster et en effectuant ses opérations sur les données. Les résultats sont ensuite écrits au cluster. C'est un moyen efficace de traiter de grands ensembles de données statiques. Spark, en revanche, est un moteur de traitement de données distribué à usage général qui traite les données en parallèle sur un cluster. Il effectue un traitement en temps réel et graphique des données.

Performance

- Hadoop Mapreduce est relativement plus lent car il effectue des opérations sur le disque et il ne peut pas fournir des analyses en temps réel à partir des données. Spark, en revanche, est conçu de telle manière qu'il transforme les données en mémoire et non dans les E / S disque, ce qui à son tour réduit le temps de traitement. Spark est en fait 100 fois plus rapide en mémoire et 10 fois plus rapide sur le disque. Contrairement à MapReduce, il peut gérer le traitement en temps réel.

Coût

- Hadoop fonctionne à un coût inférieur car il s'agit d'un logiciel open-source et il nécessite plus de mémoire sur le disque qui est relativement une marchandise peu coûteuse. Spark nécessite plus de RAM, ce qui signifie que la configuration des clusters Spark peut être plus chère. De plus, Spark est relativement nouveau, donc les experts de Spark sont rares et plus coûteux.

Tolérance aux défauts

- MapReduce est strictement basé sur un disque qu'il utilise un stockage persistant. Bien que les deux fournissent un certain niveau de défaillance de manutention, la tolérance à la défaut de Spark est principalement basée sur ses opérations RDD (ensemble de données distribuées résilientes). RDD est le bloc de construction d'Apache Spark. Hadoop est naturellement tolérant aux pannes car il est conçu pour reproduire les données sur plusieurs nœuds.

Facilité d'utilisation

- MapReduce n'a pas de mode interactif et est assez complexe. Il doit gérer les API de bas niveau pour traiter les données, ce qui nécessite beaucoup de codage, et le codage nécessite une connaissance des structures de données impliquées. Spark est conçu de bas en haut pour les performances et la facilité d'utilisation, qui proviennent de son modèle de programmation générale. De plus, les programmes parallèles ressemblent beaucoup à des programmes séquentiels, ce qui les rend plus faciles à développer.

MapReduce vs. Spark: Tableau de comparaison

Résumé

La principale différence entre les deux cadres est que MapReduce traite les données sur le disque tandis que Spark traite et conserve des données en mémoire pour les étapes suivantes. En conséquence, Spark est 100 fois plus rapide en mémoire et 10 fois plus rapide sur le disque que MapReduce. Hadoop utilise la MapReduce pour traiter les données, tandis que Spark utilise des ensembles de données distribués résilients (RDD). Spark est une amélioration Hadoop de MapReduce pour le traitement des mégadonnées. Alors que MapReduce est toujours utilisé pour l'analyse des données à grande échelle, Spark est devenu le cadre de traitement incontournable dans les environnements Hadoop.

Pourquoi Spark est plus rapide que MapReduce?

Spark processus et conserve des données en mémoire pour les étapes suivantes, ce qui le rend 100 fois plus rapide pour les données dans RAM et jusqu'à 10 fois plus rapidement pour les données de stockage. Ses RDD permettent à plusieurs opérations de carte en mémoire, tandis que MapReduce doit écrire des résultats provisoires sur un disque.

Quelles sont les différences entre Spark et MapReduce Nom au moins deux points?

Premièrement, MapReduce ne peut pas fournir des analyses en temps réel à partir des données, tandis que Spark peut gérer le traitement en temps réel des données. Et deuxièmement, MapReduce fonctionne en étapes séquentielles tandis que Spark traite les données en parallèle à travers un cluster.

Spark est-il plus avancé que MapReduce?

Spark est largement considéré comme le successeur du cadre MapReduce pour le traitement des mégadonnées. En fait, Spark est l'un des projets open-source les plus actifs de l'écosystème Hadoop et l'une des technologies les plus en vogue de l'analyse des mégadonnées aujourd'hui.

Spark a-t-il besoin de MapReduce?

Spark n'utilise pas ou n'a pas besoin de MapReduce, mais seulement l'idée et non l'implémentation exacte.

- « Différence entre le biais d'apprentissage automatique et la variance

- Différence entre la tête de mât et la plate-forme fractionnaire »